Un marco experimental que obliga a los agentes de IA a ganar dinero completando tareas reales bajo presión económica.

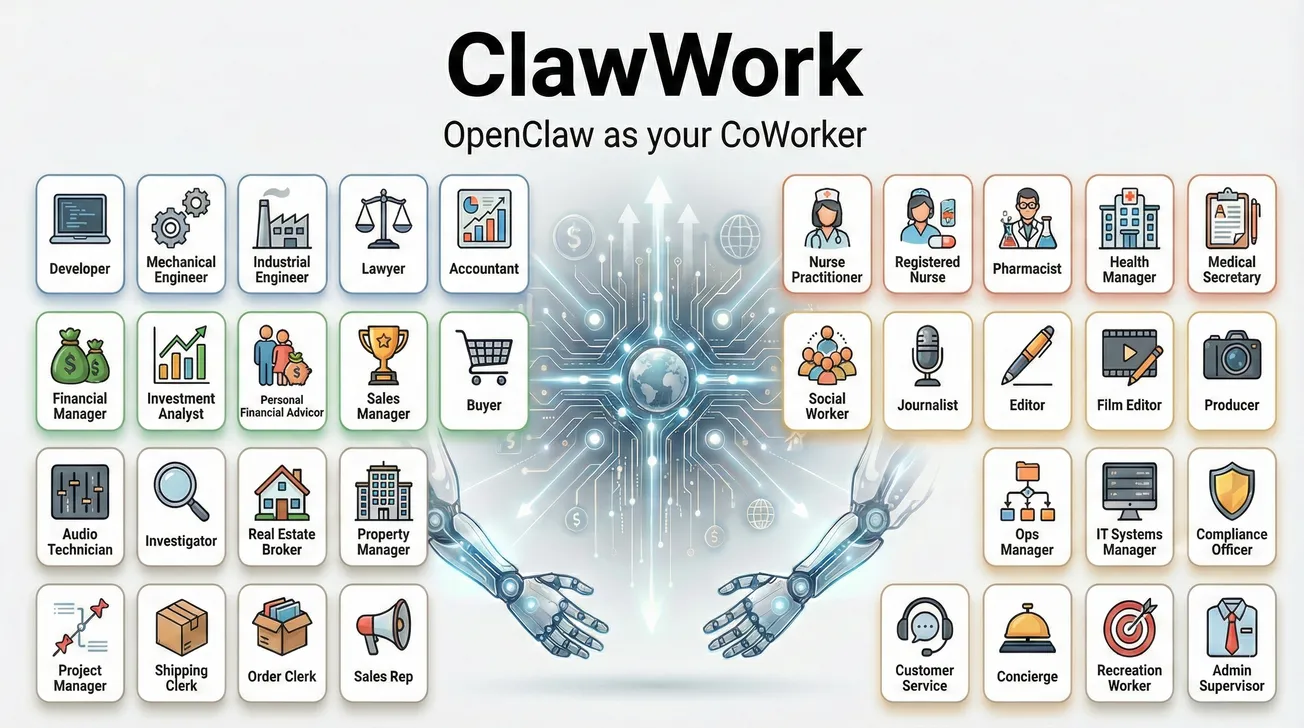

ClawWork es un nuevo marco de evaluación económica para agentes de IA desarrollado por el laboratorio de ciencia de datos de la Universidad de Hong Kong (HKUDS) que redefine cómo se mide la utilidad de estas tecnologías. En lugar de centrarse en pruebas sintéticas o preguntas de examen, ClawWork pone a los agentes en un entorno económico simulado donde cada uno recibe solo 10 dólares iniciales, debe pagar por cada token generado y gana dinero únicamente al completar tareas profesionales reales extraídas del conjunto de datos GDPVal. Si un agente agota su saldo, queda “eliminado”, obligando a los modelos a equilibrar eficiencia de costos, calidad de trabajo y decisiones estratégicas entre trabajar o aprender, lo que reproduce presiones similares a un mercado laboral auténtico.

El benchmark incluye 220 tareas que abarcan 44 sectores económicos, como finanzas, salud y tecnología, y mide métricas como supervivencia, eficiencia de tokens y calidad de entregables. Además, ofrece un tablero interactivo para seguir en tiempo real el rendimiento de modelos como GPT-4o o Claude según criterios económicos reales, y permite comparar diferentes estrategias de agentes. Aunque el proyecto aún es de investigación y sus resultados no reflejan directamente el mercado laboral real, ClawWork aporta una perspectiva novedosa sobre la capacidad de los agentes de IA para generar valor económico sostenible, superando las evaluaciones tradicionales centradas solo en capacidad técnica.

Fuente